使用认知心理学解释深度神经网络: DeepMind新研究破解AI黑箱问题

选自DeepMind

机器之心编译

近日,DeepMind在其官方博客上发表了一篇题为《Interpreting Deep Neural Networks using Cognitive Psychology》的文章,试图通过认知心理学来解决深度神经网络中的「黑箱问题」,随着神经网络被广泛应用于实际问题,这一问题正变得越发重要;并且在已被ICML收录的DeepMind最新论文《Cognitive Psychology for Deep Neural Networks: A Shape Bias Case Study》中,其证明了认知心理学工具能够揭示DNN背后隐藏的计算特性,同时也为人类学习语言提供了一种计算模型。机器之心对博客文章和论文摘要进行了编译。原文链接见文中。

深度神经网络已经学会去处理一些令人感到惊奇的任务——从图像识别和推理物体,到在 Atari 游戏和围棋上超越人类。由于这些任务和网络结构正在变得更复杂,神经网络学习的解决方案也会变得更加难以理解。

这就是「黑箱」问题,而且它正在变得越发重要,因为神经网络正在被应用于越来越多的实际应用当中。

在 DeepMind,我们正在努力去扩展用于理解和解释这些系统的工具包。在我们最新的论文中(最近被 ICML 收录),提出了一种解决此种问题的新方法,即利用认知心理学的方法去理解深度神经网络。认知心理学通过判断行为表现来推断认知层面的机理,并且涵盖大量的详述这些机理的资料和实验论证。由于我们的神经网络在一些特定任务中可以接近人类的水平,因此认知心理学方法与黑箱问题之间的关系也正在变得越来越紧密。

「黑箱」

为了说明这一点,我们的论文阐述了一个案例研究,我们使用设计好的实验来说明人类认知对于深度神经网络如何解决一个图像分类任务的理解。

我们的结果显示,认知心理学家观察到的人类行为也可以被这些深度网络展示出来。而且,这些结果也揭露了有关网络如何解决分类任务的见解,这些见解不仅有用而且令人惊奇。

在一次性词语学习模型中衡量形状偏好

在我们的案例研究中,我们考虑了儿童是怎样识别和标注物体的——这是发展认知心理学中的一个丰富的研究领域。儿童具备根据单一例子对词语含义进行猜测的能力——叫做「一次性词语学习(One-shot Word Learning models)」——我们很容易地会认为这是一个简单的过程。然而,一个来自心理学家 Willard Van Orman Quine 的经典思维实验说明了这一过程的的复杂性:

一位实地语言学家走访了语言完全不同于我们的地区。这位语言学家尝试去和当地的土著学习一些词汇,恰巧此时一只兔子匆匆路过。这位土著说了一声「gavagai」,而这位在他身边的语言学家也推断出了这个新词汇的含义。实际上这位语言学家面对的是大量的合理推断,这个「gavagai」可能泛指兔子,动物,白色的东西,也可能就是指这只特定的兔子或者「兔子中独立的一个种类」。其实他是可能做出无限个合理推断的。而人们又是怎样去选择其中的正确选项呢?

「Gavagai」

五十年后,当我们面对关于可以做一次性学习的深度神经网络的相同问题时。去考虑匹配网络,这是 DeepMind 研发的一种神经网络。这一模型使用了有关注意力和记忆力(attention and memory)研究的最新成果,可以在仅使用一种类别中的单一示例的情况下,把 ImageNet 图像进行分类,这种方法的性能表现绝对是一流的。然而,我们并不知道为了把这些图片进行分类网络都做了哪些假设。

为了使这一问题更加透明,我们借鉴了发展心理学家(developmental psychologists)(1)的工作,他已经发现了关于儿童通过利用归纳偏移来消除很多不正确推断,从而找到正确推断的证据。这些偏好包括:

全物体偏好,儿童通过参考完整物体(而非某部位)设想某个词汇(消除 Quine 对未观察到的兔子部分的忧虑)。

分类学偏好,儿童通过参考基础类别分类来设想某个词汇(缓解 Quine 把所有的动物都选择为的兔子的恐惧)

形状偏好,儿童基于物体形状设想一个词汇的含义,而非颜色或纹理(解除 Quine 把所有的白物体都认定为「兔子」的焦虑)。

我们选择测量神经网络的形状偏好,因为在人类偏好上有大量的研究工作。

认知心理学刺激物样本,我们用它来测量深度网络中的形状偏好。这些图像由印第安纳大学认知发展实验室的 Linda Smith 提供。

我们采用的经典形状偏好实验如下:我们给深度神经网络提供了三种物体图像,即探测物体、形状匹配物体(与探测目标形状相同,颜色不同)和颜色匹配物体(与探测物体形状不同,颜色相同)。然后我们度量了偏好,即将探测图像的标签分配为形状匹配图像的标签而不是颜色匹配图像标签所出现的比率。

我们使用的物体图片是印第安纳大学认知发展实验室提供的。

带有匹配网络(atching Networks)的认知心理学实验示意图。匹配网络将左侧的探测物体匹配到「A」图或「B」图。匹配网络的输出取决于其形状偏好的强度。

我们尝试使用深度神经网络(即匹配网络和 Inception 基准模型)进行这次实验,实验发现神经网络像人类一样更倾向于物体形体而不是颜色或纹理,所以它们有着「形状偏好」。

这表明匹配网络和 Inception 分类器为形状使用一个归纳性的偏好(inductive bias)而消除不正确的假设,因此我们更加清楚了神经网络到底是如何解决一次性词语学习问题。

观察形状偏好并不是我们唯一有意思的发现:

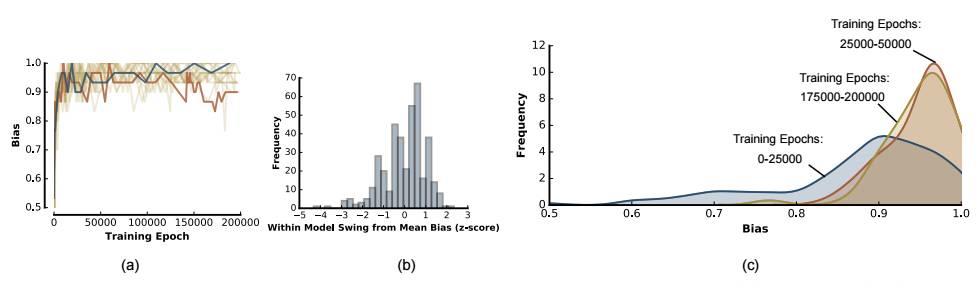

我们观察到形状偏移是在早期神经网络的训练过程中逐步出现的。这也许会联想到让人类的形状偏好到底是如何出现的:心理学家发现,较小儿童的形状偏好要比青少年小,并且成年人的形状偏好相对其他阶段是最大的。

我们发现使用不同的随机种子进行初始化和训练会得到不同程度偏移的神经网络。这就说明在深度学习系统进行实验时,我们必须使用大量已训练的模型来得出有效的结论,这正像心理学家不会根据单个主题得出一个结论一样。

我们发现神经网络即使在形状偏好十分不同时,它都可以实现相同的一次性学习性能。因此这证明了不同的神经网络能发现复杂问题多种等价高效的解决方案。

这一在标准神经网络架构中未被认识到的偏好发现表明,使用人工认知心理学解释神经网络解决方案的潜力巨大。在其他领域中,来自 episodic 记忆文献的洞见可用于理解 episodic 记忆架构,来自语义认知文献的技术可被用于理解形成概念的模型。这些以及其他领域丰富的心理学文献,赋予了我们一个极为强大的工具来解决神经网络黑箱问题,更深入地理解神经网络的行为。

论文: Cognitive Psychology for Deep Neural Networks: A Shape Bias Case Study

论文

摘要:深度神经网络(DNN)在多种复杂任务中具有优势,可以达到超出人类能力的表现。虽然过去的大量研究都旨在增进对于模型本身的理解,但却少有研究将其用于人类认知心理学中问题解释、理论和试验方法。为了探索这些工具的潜在价值,我们在发展心理学中选择了一个完善的分析方法来解释人类儿童如何学习事物的语言标签,同时将这种分析应用到 DNN 中。

通过使用受到原始认知心理学启发的数据集进行实验,我们找到了在 ImageNet 上迄今为止表现最佳的一次性学习模型,它展示了与人类相似的偏见:偏向于以形状而不是颜色对物体进行分类。这种对形状偏好的量级不仅出现在整体识别中,也出现在子模型里,甚至会在训练时在子模型中产生波动。这些结果证明了认知心理学工具能够揭示 DNN 背后隐藏的计算特性,它同时也为人类学习语言提供了一种计算模型。

图 1:认知心理学数据集中的示例图像。该数据集由认知心理学家 Linda Smith 提供,其设计初衷是控制物体大小和背景。

图 2:带有不同随机初始化种子的模型及其形状偏好,这些模型在训练计算中使用的是 CogPsyc 数据集。

图 4:该散点图展示匹配网络(Matching Network/MN)形状偏好和 Inception 形状偏好的线性相关性。

图 5:带有不同随机初始化种子的模型及其形状偏好,这些模型在训练计算中使用的是真实世界(real-world)数据集。

最后,在本研究工作中,我们展示了如何利用认知心理学技术来帮助我们更好地了解 DNN。作为一个案例研究,我们使用了两种十分强大但又不甚了解的深度神经网络(Inception 和匹配网络)测度量形状偏好。我们的分析在一定程度上揭示了这些模型的未知属性。更广泛地说,我们的研究工作为使用认知心理学技术探索深度神经网络提供了新的途径。

参考文献

Markman, Ellen M. Constraints children place on word meanings. Cognitive Science, 14(1):57–77, 1990.

Markman, Ellen M and Hutchinson, Jean E. Children’s sensitivity to constraints on word meaning: Taxonomic versus thematic relations.Cognitive Psychology, 16(1):1–27, 1984.

Markman, Ellen M and Wachtel, Gwyn F. Children’s use of mutual exclusivity to constrain the meanings of words. Cognitive Psychology, 20(2):121–157, 1988.

Landau, Barbara, Smith, Linda B, and Jones, Susan S. The importance of shape in early lexical learning. Cognitive Development, 3(3):299–321, 1988.

✄------------------------------------------------