10分钟内找到癌症遗传基因,它是怎么做到的?

内容来源:本文为东方出版社书籍《一本书读懂人工智能》读书笔记,笔记侠作为合作方,经授权发布。封图设计&责编 | 丽丽第 2662 篇深度好文:5467 字 | 10分钟阅读

读书笔记·人工智能

本文优质度:★★★★★ 口感:内蒙古牛肉

笔记侠说:

经历过辉煌也跌入过谷底的人工智能,终于迎来了它的又一次热潮。

一次次刷新人们认知的AI究竟是什么?已经在哪些领域获得应用?还将发展成怎样令人惊讶的强人工智能?

接下来将为你呈现一个真实的AI应用世界。

以下enjoy~

自从AlphaGo战胜了围棋职业棋手,大家的内心就有些惶惶然。职业棋手界将来怎么办?

你会不会也被AI取代?

短跑选手不可能战胜汽车,但不会因此失去来自人们的赞赏。职业棋手也一样,不会马上丧失自身的价值。

所以不要怕。我们的现在和未来不一定是人类对战人工智能。现在已经有很多机器人公司在生产能和人类肩并肩工作的“协作机器人”了。

我们看到一丝希望:今年,这个AI或许就能站在你的那一边了。

一、AI在各个领域的应用

丘比采用AI帮助判断是否有异物混入蛋黄酱或沙拉酱等食品。

如果遇到难以判定的情况,再依靠人类检测员。这样能够提升检测速度,还能减轻工作人员的负担,因为AI可以24小时作业。

在农业方面,与父母一起在日本种植黄瓜的小池诚正在研发能够判定黄瓜等级,并自动进行分类作业的系统。

先让系统学习大约9000份黄瓜图像数据。

系统内的相机会拍摄放在分类作业台上边的黄瓜,利用TensorFlow的AI系统从图像中抽取“长度”“弯曲状况”“粗细度”等特征,自动分为6类。

不过如果图像数据质量如果不均匀,会影响精确度。昼夜光的变化会使图像亮度发生变化,如何收集稳定质量的图像数据是关键。

AI可以帮助医生和研究人员。美国IBM提供一种能够回答提问功能的云服务Watson Genomic Analytics(WGA)。

WGA经过了2000万篇以上的论文概要、1500万个以上的医疗相关专利数据的训练。

东京大学医科学研究所宫野悟教授使用大肠癌的实验数据验证WGA的性能,只花了10分钟就找到了有可能成为癌症病因的遗传基因。

如果靠人力来查,需要花两个月的时间。

AI能够以人事数据为基础判断人才适合于何种工作、擅长发挥怎样的作用。

WorksApplications公司的ERP (综合基础业务系统)“HUE”就具备这样的功能。

它可以分析职员的年龄、性别、职务经验、薪金等数据,抽取在各个职位上过去做出过优秀业绩的公司职员的倾向性数据,判断人才的适应性。

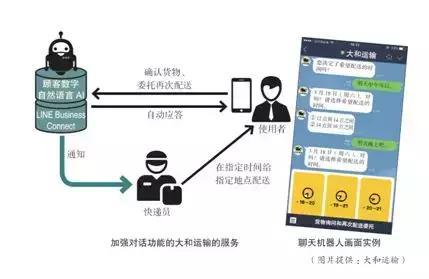

大和运输在LINE上利用能够建立自动应答系统的“LINE商业联系”服务开展新型服务。这样通过聊天就能够通知送货上门的时间以及有关货物的相关咨询。

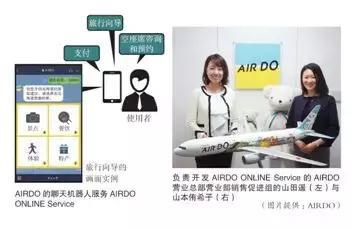

AIRDO航空公司通过聊天机器人的双向互动,缩短与顾客的距离,开展有效的市场营销活动。

2017年3月通过LINE的对话服务开展特惠出售机票的活动。活动开始后,点击率暴涨,造成了1分钟服务器瘫痪的状况。

其聊天机器人“AIRDO ONLINE Service”,能够完成机票的预订、确认、登机手续等。

这些只是AI能做到的一小部分事情。这几年AI飞速地发展着,似乎只要你能想到的,技术就能做到。可是仅仅满足“技术上可行”就够了吗?

二、自动驾驶技术将很快走向实用

纯粹是错觉

有时候除了技术本身,还有其他方面需要我们考虑,自动驾驶技术就是一个典型的例子。

目前自动驾驶技术发展得十分快。市面上已经有驾驶辅助系统,世界各汽车生产厂商正铆足了劲儿开展研发。

形势如此大好,不由令人感觉再过不久就能在普通道路上见到自动驾驶汽车。

但是,自动驾驶哪儿能这么容易实现呢?

运用AI的自动驾驶技术的研发可以追溯到21世纪头一个10年的中后期,谷歌公司基于其当时CEO劳伦斯•爱德华•佩奇的想法启动了自动驾驶汽车研发项目,此举后来广为人知。

自动驾驶技术要走向实际应用,道路非常漫长。

进入21世纪20年代,ROS(Robot Operating System)流行起来,机器人软件技术广为人知。

在ROS热潮、机器人热潮的背后,谷歌及汽车厂商一直在默默地进行自动驾驶汽车的研发。

2015年10月丰田开展了自动汽车测试,自此丰田将研发自动驾驶汽车的事公之于众,还收购相关技术公司或与其合作。

2016年1月更是为研究AI在硅谷成立了丰田研究所(TRI,Toyota Research Institute)。

本田与谷歌合作,正在共同开发完全自动汽车。

日产总裁卡洛斯·格恩在2017年1月透露,日产正在开展完全自动驾驶汽车的实验。戴姆勒、福特、BMW等也纷纷表示正在研发自动驾驶汽车。

美国已经允许在公路上开展自动驾驶测试。

装载了5万瓶啤酒的自动驾驶货车成功以时速120英里(约190km)的速度行驶的新闻还记忆犹新。

日本也在2016年11月进行了首例公路测试,虽然测试时公路上施行了道路管制。

仅从技术角度来讲,自动驾驶汽车的平均事故率已经低于人类驾驶。

但解决了技术问题并非就扫除了商业化的所有障碍,不管自动驾驶汽车的事故率降到多低,依然存在发生事故的可能性。

自动驾驶汽车在紧急情况下该如何处理?相关的伦理、法律问题怎么解决?这样看来,自动驾驶要发展离不开相关法律制度的健全。

说到底机器学习只是让计算机学习以前的旧有数据,其机制是让机器学习过去已发生的事情。

AI无法处理迄今从未出现过的情况,因此需要让它学习在这些紧急状态下如何依据法律法规正确处理问题。

例如:你和家人坐在自动驾驶的汽车里,路右边是放学后的孩子,左边是赏花的老人,而此时前边行驶着的大货车突然刹车,你们眼看就要撞上去。

撞上去后你和家人很可能就此丧命,不撞上去的话又刹不住车,不是威胁右侧孩子们的安全就是威胁左侧老人们的安全,此时自动驾驶汽车面临如此紧急的情况要怎样处理呢?

此时有几种选项,比如“应该选择转向人少的一方”“孩子还有大好的未来,应该转向左侧”“应该直接撞上去”等。

不管自动驾驶汽车选择哪种做法,都不能一概而论地说它做对了或做错了。

怎么选择正确,不同国家的法院都是具体案例具体讨论的,并未达成社会共识。

没有达成社会共识就意味着无法对人进行数值化衡量,而只要不能用数值衡量就不能由人预先设定程序。

当然,不同选项的优先顺序构成了机器学习的评价标准。如果没有评价标准,就算AI计算多少遍也得不出结果。

换句话讲,用数值衡量人是一个绕不过去的弯儿。

进行机器学习时问题更多。各国文化、道德、伦理观念各不相同,虽然交通法大致框架一致,但涉及上述紧急情况下如何判断行为的妥当性时则各国各不相同。

有些药在美国的药店里就能买到,但在日本却属于禁药范围。人工智能也可能出现类似情况。

涉及伦理问题,要在世界范围内统一标准,不是国家各自修改一下法律就能解决的。

需要国家间进行协调,而这难度相当大。

三、“AI威胁论”源于无知:

3个误解以及真正的课题

误解1:终有一天AI 可能会自发产生消灭人类的想法。

回答1:以现在的AI技术,离“拥有自己的想法”还相距甚远。

现在的AI,没有人类输入的对话数据,是不可能生成对话的,也就是说现在的对话AI还没有脱离鹦鹉学舌的阶段。

从前,AI机器人在电视节目中说“要消灭人类”,而成为热议的话题,这其实是由于提问人提问“你想消灭人类吗?”机器人只是鹦鹉学舌地进行了回答。

通用人工智能的出现确实会对社会造成很大冲击,但如果问它所带来的威胁是否大到现在就需要给AI的开发加以制约,或者问现在的技术是否已经发展到这种程度,回答只能是No。

即使在第3次AI热潮中,可称为智能中枢的语言功能的进展仍比较缓慢。

误解2:AI 是黑匣子?由于缺乏决策透明度因此无法应用。

回答2:关于使AI不成为完全的黑匣子的开发工作正在向前推进。

通常的程序,通过追踪代码能够确认算法,但在深度学习中,没有人类能读懂的理论代码,只有表示各神经网络连接强弱的参数。

深度学习与通常的程序相比较,黑匣子性质更强烈,这是毋庸置疑的。

但现在,对以深度学习为首的AI技术,人们不断地做尝试提高其透明度的手法,已经不能一概而论地称“AI就是黑匣子”。

TRI的CEO(首席执行官)吉尔•布拉德先生所研究的是“可解释的自动驾驶AI”。

将自动驾驶软件划分为通过光学传感器和雷达信息来识别物体存在的“认知层”和以此认知为基础决定驾驶员行动的“行动层”。

后者是以一般的程序形式组成的,能够被解析。

美国英伟达公司开发的以深度学习为基础的自动驾驶软件PilotNet是采取认知层和行动层均由神经网络来承担的所谓端对端原理的方法。

该公司同时在开发一项技术,通过该技术,可以看到经过深度学习的神经网络是注视前方图像的哪里在实施导向的。

通过提升神经网络行动的可视化,使黑匣子不再是黑匣子。

在AI的透明度方面,有比深度学习的黑匣子性更加重要的问题:

设想一下:某个私人助手程序向客户推荐“如果饿了,推荐您去A店”。如果是因为A店向提供助手服务的企业付了广告费,作为回报,私人助手程序提出了这个建议,那么这个建议就可以说是一种秘密行销。

在私人助手对话的用户界面,如果要区分广告和非广告,就会使对话显得不自然。总不能让AI说:“推荐您去A店和B店。前者是广告,后者非广告。”

不仅仅是私人助手,只要是AI具有帮助人类做决定,或给予建议的功能,都有可能产生这个问题:“这个AI究竟是站在谁的一边?”

是否需要定一个规则来公开AI背景中所有的利益关系呢?

误解3:让自动驾驶之类的AI 来对人类生命实施抉择是对人类尊严的冒犯?

回答3 :实际上由AI 对生命实施抉择的情况几乎没有。

伦理学领域有一个知名的“电车难题”:“如果自动驾驶的汽车马上要与有许多孩子乘坐的汽车相撞时,自动驾驶AI为拯救多数孩子的性命,将方向盘转向悬崖,牺牲车内司机的性命,这种判断在伦理上是否许可呢?”

实际上,许多AI开发者没有把电车难题当作现实中的障碍。

TRI的CEO吉尔•布拉德先生在记者见面会上回答道:“原本不使人陷入电车难题那样的危机状态,正是自动驾驶AI应该发挥的作用。”

自动驾驶AI通过能观察360度的激光传感器和各种图像传感器,能够观察到人类驾驶者所不能看到的死角。正因此,才能比人类更容易避免未知的危机。

假如陷入了相当于电车危机的危机状况,自动驾驶AI应该不会转方向盘,而是优先踩急刹车减速。

这样可能会增加与后边车产生追尾的风险,但追尾一般会追究后边车的责任,而为避免事故的急刹车,无论在法律上还是伦理上,都没有问题。

原本连伦理学家都无法解决的电车难题,却给AI强加伦理责任,可以说这样做本身就不正常。

当遇到突发危险时,AI只要能采取比人类更强的应对措施,就应该算是及格了,我们难道不应该采取这样的评价方式吗?

实际上自动驾驶AI比人类驾驶员具有更高的避免事故发生率。美国特斯拉汽车的半自动驾驶功能Autopilot的事故发生率已经比人类驾驶的低了。

这样就会产生与AI相关的一个新的伦理问题:“将驾驶推给人类,在伦理上是正确的吗?”

例如,人类驾驶员因为疲劳,缺乏睡眠,而造成蛇形驾驶,这样发生事故的危险增加。

这种情况下,如果自动驾驶AI违反驾驶员的意志,夺过汽车控制权,代为驾驶,或者将其停在安全位置,就能够减少事故发生。

AI违背用户的意图抢夺驾驶控制权,这是无法容许的违背人类尊严的行为吗?还是交托于事故发生率更低的AI更符合伦理观?

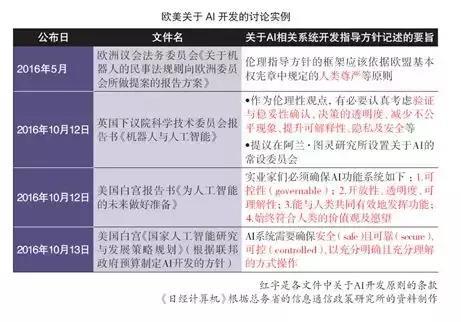

尽管AI威胁论的说法有些夸大其词,但现在许多AI技术确实已经面临伦理方面的课题。饱受批判的“AI开发指导原则”在唤起人们的讨论这一点来说,可以说是发挥了重要的作用。

AI伦理与开发指导原则

为了保护人类的安全,防止AI“走上邪路”,开发AI应该遵循什么原则呢?世界各国都有自己的思考。

日本总务省所提出的开发原则是透明度、可控性、确保安全、安全保护、隐私保护、伦理、支持使用者、解释责任8项原则。

关于其中的“透明度”,也不是说“没有透明度”的AI不应该使用。不光是AI,有时候在黑匣子的状态下使用技术也是没办法的事。

有一些技术人们并不能完全解释清楚,却被广泛使用,飞机就是代表性的例子。

飞机在空中飞翔的结构中也有没弄清楚的部分,但在使用时,会先商定如何减少事故,以及事故发生时如何处理。

结果因飞机失事所带来的死亡事故与汽车交通事故相比较,正在大幅减少,飞机正在成为最安全的一种交通工具。也可以从同样的角度考虑AI的使用。

关于“可控性”,最终会发展至“是否设置死亡开关”的相关讨论。有些讨论就涉及当自动驾驶车失去控制乱跑,或发生机器人叛乱时,应该设置死亡开关。

但在许多AI联动的AI网络中,只制止一个AI,却无法控制整体,可能使情况变得更加糟糕。

例如,在由自动驾驶汽车组成的车队里,其中一名驾驶员踩刹车是不被允许的。

在欧洲汽车制造商中,已经在讨论“随着自动驾驶AI的发展,应该禁止对情况的判断能力不如AI的人类介入驾驶”。

考虑到这种影响,对于不应该设置AI死亡开关的意见也是合理的。

类似这样的争议和讨论还有很多。

但无论如何,对于AI开发者来说,现在都是一个无与伦比的好时代。开发者能够利用的工具非常齐备,只要有创意,就有可能实现。

相信AI今后还将有极为广阔的发展空间,我们拭目以待。

*文章为讲者独立观点,不代表笔记侠立场。