神经网络的巧妙组合,乳腺癌诊断准确率竟媲美专业医生

乳腺癌是一种极其常见的肿瘤。根据美国癌症协会估算,每个女人一生罹患乳腺癌的几率约为 12%。在美国,因乳腺癌死亡的女性人数仅次于肺癌,平均致死率约为 2.6%。而近年我国乳腺癌发病率的增长速度也呈上升趋势,发病率为女性恶性肿瘤的第一。

由于早期乳腺癌的5年生存率高达 98-100%,而晚期(扩散后)的生存率会降低到20%,因此,乳腺癌的“早发现、早治疗”已经成为了现代医学主要研究领域之一。

最近,美国纽约大学(NYU)数据科学中心的研究人员,联合 NYU 朗格尼医学中心(NYU Langone Medical Center),发明了一种基于多种现有神经网络模型的新型乳腺癌筛模型。这个模型最终的诊断准确率远超单个放射科医生。作为辅助,也可以让一名放射科医生的诊断率媲美 12 名医生“会诊”的水平。

(来源:Pink Ribbon International)

他们采取了多个十分聪明的手段,有效解决了这类算法面临的医学成像数据瓶颈、阳性数据过少、图像分辨率过高三大难题。这项研究的意义不仅仅在于一个高效的乳腺癌检查模型,而是其解决难题的思路十分值得借鉴。

首个难题:数据瓶颈

“用 AI 来为医疗赋能”一直是 AI 研究人员的一大目标。目前也有很多机构尝试将深度学习技术应用于医学成像分析,尤其是与癌症相关的研究,但“巧妇难为无米之炊”,许多医学 AI 研究都遭到了数据瓶颈。

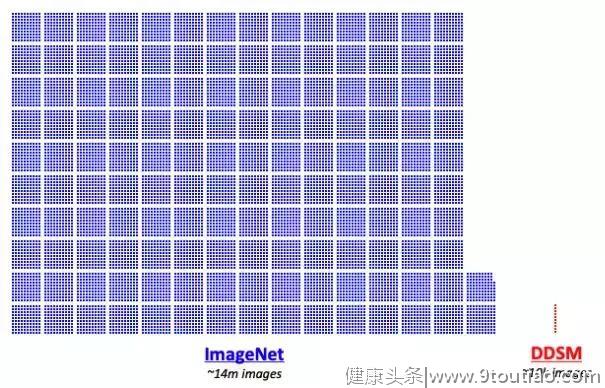

图 | ImageNe t数据库和 DDSM 数据库体量对比(来源:Jason Phang/Medi

训练一个图像分类的深度学习模型需要海量数据。在一般情况下,研究人员可以用包含数千万张图片的 ImageNet 数据库。但若想训练一个乳腺癌识别模型,只能寄希望于专业的医疗数据库,比如主流的开放式乳房 X 光图像库 CBIS-DDSM。可惜,它只有 1 余万张图像,远远无法满足深度学习模型训练的需要。

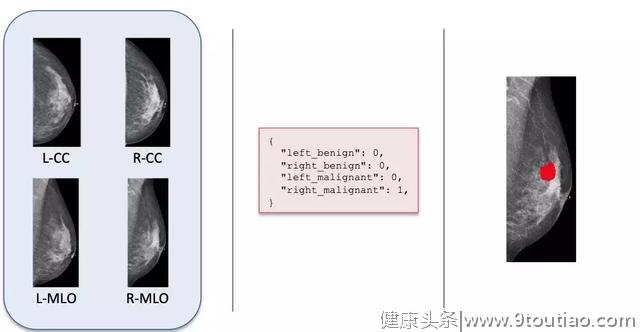

为此,研究团队与 NYU 朗格尼医学中心联手,专门打造了一个乳房 X 光图像数据库。它收集了 22.9 万余例匿名的乳房 X 光检查,覆盖超过 14.1 万名病人。其中,每例检查包含至少 4 张图片:左右乳房各两张(轴位 CC 和侧斜位 MLO),总计超过100万张。

(注:轴位和侧斜位代表拍摄角度,可以简单理解为垂直方向和水平方向,但严格意义上讲,两者并不相互垂直,也不是完全垂直或水平。)

图 | 乳房摄影图

研究人员表示,由于约有 7000 个案例进一步采取了可以确认是否存在肿瘤的乳房活检,与 X 光图像对应的活检报告因此成为了绝佳的标签(“良性肿瘤”或“恶性肿瘤”,余下没有活检的案例则被标为“无肿瘤”)。

它们还邀请了 12 名放射科医生,标注出这些 X 光图像中病变所在的具体像素区域,进一步提高了训练数据集标签的精准度。

这样一来,研究人员就通过准确的诊断数据(活检报告)和技巧(医生标注),初步掌握了判断标准,可以用来训练模型识别癌症,同时尽可能避免假阳性和假阴性误诊。

第二难题:阳性数据过少

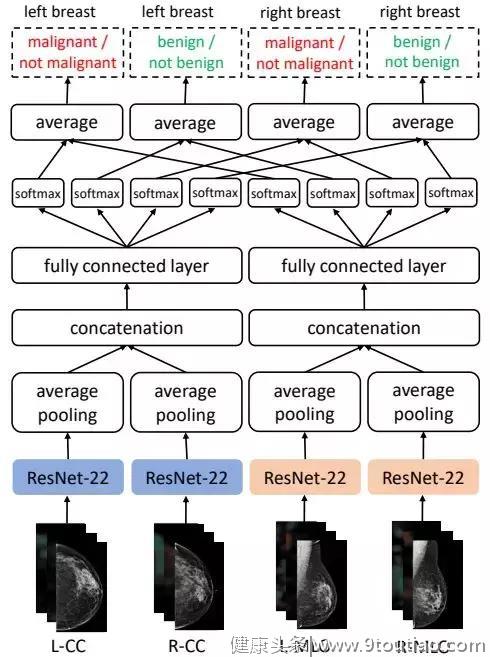

在满足了模型训练的图像要求后,研究团队建立了一个多视角卷积神经网络模型(Multi-view CNN),学习如何识别乳腺癌。

图 | 多视角卷积神经网络模型

它将输入图片分成两大类和四小类,前者对应轴位和侧斜位,后者则对应左乳房轴位,右乳房轴位,左乳房侧斜位和右乳房侧斜位。之所以这样分类,是因为不同角度拍摄的乳房图片,成像方式不同,需要使用不同的权重,才能准确地识别特征。

每张图片都会输入到 ResNet 网络中,得出其隐层表征,经过平均池化层和级联层提取、整合和拼接特征,得出一个 512 维矢量,再放入两个核心全连接层中,用神经元计算,最后经过 softmax 和 average 函数求出四个输出值,分别对应左右乳房的良性和恶性预测值。

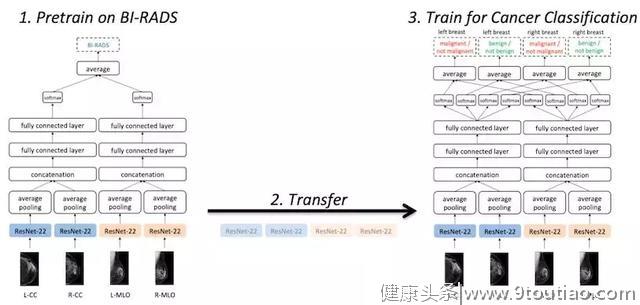

但由于阳性数据过少,模型的泛化性和准确率还有待提高。研究人员采用了预训练(Pre-Training)+ 迁移学习(Transfer Learning)的办法,预先建立一个类似问题的模型,再迁移到乳腺癌分类模型中。这并不是什么新技术,但效果很棒。

图 | 引入预训练模型(来源:Jason Phang/Medium)

他们使用的模型几乎与上述模型一样,只不过分类方式从良性和恶性,转变成了乳腺癌检查使用的主流 BI-RADS 分类系统。这是一种标准化的乳腺病变诊断类别系统,共分为 7 大类,医生可以根据 X 光图像、超声波和核磁共振等报告中的乳腺组织细节,比如是否有肿块和钙化,按严重等级分类。

虽然对于神经网络来说,这种分类方式有时无法给出确切结论,但它足以起到参考作用,模型能够学习哪些图片更像是良性的,哪些更像是恶性的。由此得到的 ResNet 权重,可以当做乳腺癌分类模型的初始参数。

第三难题:分辨率过高

解决了训练数据问题,团队所面临的最后一难题就是图像分辨率过大。乳房 X 光图像的分辨率处于 2000 x 2000 像素的级别。相比之下,一般 ImageNet 模型的输入都是 256 x 256 像素。这个级别的医学图像已经远超普通卷积网络和 GPU 内存的承受能力。

但是如果将 X 光图像压缩,又会影响到预测准确率,毕竟是医学影像,极小的细节都可能是诊断的关键,差之毫厘,谬以千里。

面对这个难题,研究团队的思路很简单,直接采用图像块分类方法(patch classification),将一张张超过 2000 x 2000 大小的照片,随机裁剪成很多256 x 256 的小图像。

如果一个小图像与之前医生标注的病变区域重合,就给它打上良性、恶性或阴性的标记。研究团队尝试了大量的已有模型,最终挑选了表现最佳的 DenseNet-121,专门训练它分类小图像。

在此基础上,他们还创造了乳房 X 光片的小图像分类热图(heatmap),可以显示出良性预测和恶性预测的差异图。

最终,研究人员融合了小图像分类模型和乳腺癌分类模型:前者输出的两幅预测热图,再加上乳房X光照片,三幅图片共同组成了后者的输入值,供其预测是否患有乳腺癌。

这样一套看似复杂的“双剑合璧”流程,其实只是将多个已有的深度学习模型灵活组合,用新颖的思路解决了数据难关,获得了相当不错的预测效果。

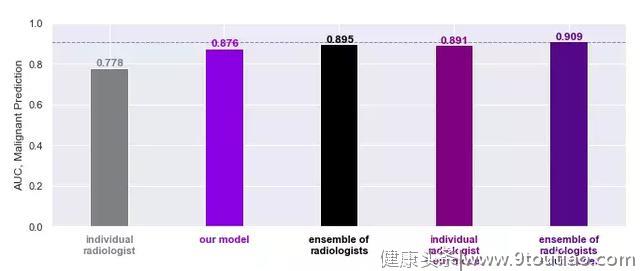

研究结果显示,该分类模型识别恶性癌变的 AUC 值高达 0.895,良性 AUC 值则为 0.756。AUC 是评价分类器效果的指标,介于 0 到 1 之间。简单来说,AUC 越高,分类器的正确率就越高。

图 | AUC值对比(来源:Jason Phang/Medium)

经过对比,它的准确率大幅超过单个医生的平均水平。最重要的是,单个医生使用分类模型作为辅助时,他们的表现足以媲美 12 名放射科医生“会诊”的整体水平。(模型+12 名医生甚至取得了最高的 AUC 值 0.909),证明双方确实可以互补,共同推动乳腺癌临床诊断技术的进步。

结语

目前,乳腺癌的主流筛查手段,主要围绕体格、影像学和病理学检查三个方面,其中影像学作为辅助诊断工具,以 X 光、超声波和核磁共振为主,对医生的职业水平提出了非常高的要求,需要大量专业培训和长期临床经验。所以,面对大量需要例行检查的女性,专业的放射科医生一直处于供不应求的状态。

而从乳房 X 光照片中寻找可能存在的肿瘤组织又是一个需要极其专注的工作。在高强度的工作环境中,医生难免会因身体和精神的双重疲劳而判断失误,贻误病情。

所幸,随着AI技术,尤其是深度学习技术的发展,诸如卷积神经网络(CNN)一类的计算机视觉模型逐渐兴起,它们在物体识别、分类和鉴定等领域都有惊人表现。这与现代医学对提升诊断效率和准确率的迫切需求不谋而合。

未来,研究团队将继续挖掘乳腺癌分类模型的潜力,尝试探索更多可能,比如是否可以引入病人相关的病史和医疗数据,作为诊断的辅助数据?能否解释模型的分类原理,进而启发医生寻找新的诊断思路?

或许和这项研究一样,答案就深藏在现有技术中,静待人们去发现。